OpenAI روز چهارشنبه از عرضه دو مدل استدلالی هوش مصنوعی به نامهای o3 و o4 مینی خبر داد. این مدلها برای متوقفکردن پاسخدهی و بررسی دقیق پرسشها پیش از ارائه پاسخ طراحی شدهاند.

این شرکت از o3 بهعنوان پیشرفتهترین مدل استدلال خود یاد میکند که در آزمونهایی برای سنجش تواناییهای ریاضی، کدنویسی، استدلال، علوم و درک بصری از مدلهای قبلی این شرکت عملکرد بهتری دارد. در همین حال، o4 مینی تعادلی رقابتی بین قیمت، سرعت و عملکرد ارائه میدهد؛ سه عاملی که معمولاً توسعهدهندگان هنگام انتخاب یک مدل هوش مصنوعی برای برنامههای خود در نظر میگیرند.

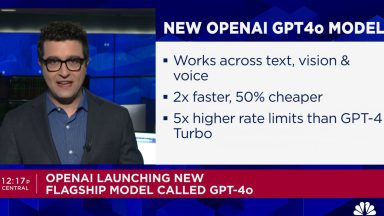

مشخصات مدلهای هوش مصنوعی o3 و o4 مینی

برخلاف مدلهای استدلال قبلی، o3 و o4 مینی قادرند از ابزارهای موجود در ChatGPT مانند مرور وب، اجرای کدهای Python، پردازش تصویر و تولید تصویر برای تولید پاسخ استفاده کنند. از امروز، این مدلها به همراه نسخهای از o4-mini به نام o4-mini-high که زمان بیشتری صرف تدوین پاسخها میکند تا قابلیت اطمینان آن افزایش یابد، برای مشترکان طرحهای پرو، پلاس و Team OpenAI در دسترس هستند.

این مدلهای جدید بخشی از تلاش OpenAI برای پیشیگرفتن از گوگل، متا، xAI، آنتروپیک و دیپسیک در رقابت جهانی شدید هوش مصنوعی هستند. اگرچه OpenAI اولین شرکتی بود که مدل استدلال هوش مصنوعی (o1) را عرضه کرد، رقبا بهسرعت نسخههای خود را ارائه کردند که در برخی موارد با عملکرد مدلهای OpenAI برابری یا حتی از آن فراتر رفتند. در واقع، مدلهای استدلال در حال تسلط بر این حوزه هستند زیرا آزمایشگاههای هوش مصنوعی تلاش میکنند عملکرد بیشتری از سیستمهای خود استخراج کنند.

سم آلتمن، مدیرعامل OpenAI، در ماه فوریه اعلام کرده بود که شرکت قصد دارد منابع بیشتری به یک جایگزین پیشرفته اختصاص دهد که فناوری o3 را در خود دارد. اما به نظر میرسد فشار رقابتی در نهایت باعث تغییر تصمیم OpenAI شد.

OpenAI ادعا میکند که o3 در آزمون SWE-bench (که تواناییهای کدنویسی را بدون چارچوبهای سفارشی میسنجد) عملکردی در سطح جهانی ارائه داده و امتیاز ۶۹.۱٪ کسب کرده است. مدل o4 مینی نیز عملکرد مشابهی با امتیاز 68.1٪ نشان داده است. بهترین مدل قبلی، یعنی o3 مینب، در این آزمون امتیاز 49.3٪ و مدل Claude 3.7 Sonnet امتیاز 62.3٪ را به دست آوردند.

OpenAI ادعا میکند که o3 و o4 مینی اولین مدلهای آن هستند که میتوانند «با تصاویر فکر کنند». در عمل، کاربران میتوانند تصاویری مانند طراحیهای روی تخته وایتبرد یا دیاگرامهای فایلهای PDF را به ChatGPT آپلود کنند و مدلها این تصاویر را در مرحله «زنجیره تفکر» خود تحلیل میکنند و سپس پاسخ میدهند. با این توانایی جدید، o3 و o4-mini میتوانند تصاویر تار و کمکیفیت را درک کنند و وظایفی مانند زومکردن یا چرخاندن تصاویر را هنگام تحلیل انجام دهند.

علاوه بر قابلیتهای پردازش تصویر، o3 و o4-mini میتوانند کدهای Python را مستقیماً در مرورگر شما از طریق قابلیت Canvas در ChatGPT اجرا کرده و هنگام پرسش در مورد رویدادهای جاری در وب جستجو کنند.

علاوه بر ChatGPT، هر سه مدل o3، o4 مینی و o4 مینی از طریق نقاط انتهایی مختص توسعهدهندگان، یعنی Chat Completions API و Responses API نیز دردسترس خواهند بود. این امکان به مهندسان اجازه میدهد تا با استفاده از مدلهای شرکت، برنامههایی را با نرخهای مبتنی بر مصرف بسازند.

OpenAI هزینه نسبتاً پایینی برای مدل o3 دریافت میکند. هزینه ورودی این مدل 10 دلار به ازای هر میلیون توکن (تقریباً معادل 750000 کلمه، طولانیتر از مجموعه کتابهای «ارباب حلقهها») و هزینه خروجی آن 40 دلار به ازای هر میلیون توکن است. برای مدل o4 مینی، OpenAI همان هزینه مدل o3 مینی را دریافت میکند: 1.10 دلار به ازای هر میلیون توکن ورودی و 4.40 دلار به ازای هر میلیون توکن خروجی.

OpenAI میگوید که در هفتههای آینده قصد دارد نسخهای به نام o3 پرو را عرضه کند که از منابع محاسباتی بیشتری برای تولید پاسخهای خود استفاده میکند. این مدل بهطور انحصاری برای مشترکان طرح پرو در ChatGPT دردسترس خواهد بود.

سم آلتمن، مدیرعامل OpenAI، اشاره کرده است که o3 و o4 مینب ممکن است آخرین مدلهای استدلال مستقل این شرکت در ChatGPT پیش از GPT-5 باشند. OpenAI گفته است که GPT-5 مدلهای سنتی مانند GPT-4.1 را با مدلهای استدلالی ادغام خواهد کرد.

دیدگاهتان را بنویسید