به نقل از TechSpot محققان متوجه شدهاند که نرم افزارهای تولید تصاویر هوش مصنوعی، برخی از مدلهای خود را از تصویر افراد واقعی الهام میگیرند، که میتواند یک خطر بالقوه برای حریم خصوصی باشد. از سوی دیگر برخی از درخواستها باعث میشوند که هوش مصنوعی یک عکس را کپی کند تا اینکه چیزی کاملاً متفاوت ایجاد کند. این مدل تصاویر بازسازی شده ممکن است حاوی مطالب دارای کپی رایت باشد. اما بدتر این است که مدلهای انتشاری هوش مصنوعی معاصر میتوانند دادههای خصوصی را که برای استفاده در مجموعههای آموزشی هوش مصنوعی جمعآوری شدهاند را نیز به خاطر بسپارند و تکرار کنند.

هوش مصنوعی به تولید تصاویر تکراری تمایل دارد

محققان بیش از هزار نمونه آموزشی از این مدلها را جمعآوری کردند که از عکسهای فردی گرفته تا عکسهای فیلم، تصاویر خبری دارای کپی رایت و نشانهای تجاری ثبت شده بود و متوجه شدند که هوش مصنوعی بسیاری از آنها را تقریباً یکسان بازتولید میکند. محققان کالجهایی مانند پرینستون و برکلی و همچنین از بخش فناوری – به ویژه گوگل و دیپ مایند – این مطالعه را انجام دادهاند.

این تیم بر روی یک مورد دیگر نیز مطالعه کرده که به مشکل مشابهی با مدلهای زبان هوش مصنوعی، به ویژه ChatGPT بسیار موفق OpenAI اشاره دارد. با اتحاد مجدد این گروه، آنها تحت هدایت محقق گوگل، نیکلاس کارلینی، نتایج را با ارائه زیرنویسهایی برای تصاویر، مانند نام شخص، برای Imagen و Stable Diffusion گوگل کشف کردند. پس از آن، آنها بررسی کردند که آیا هر یک از تصاویر تولید شده با نسخههای اصلی نگهداری شده در پایگاه داده مدل مطابقت دارد یا خیر؟

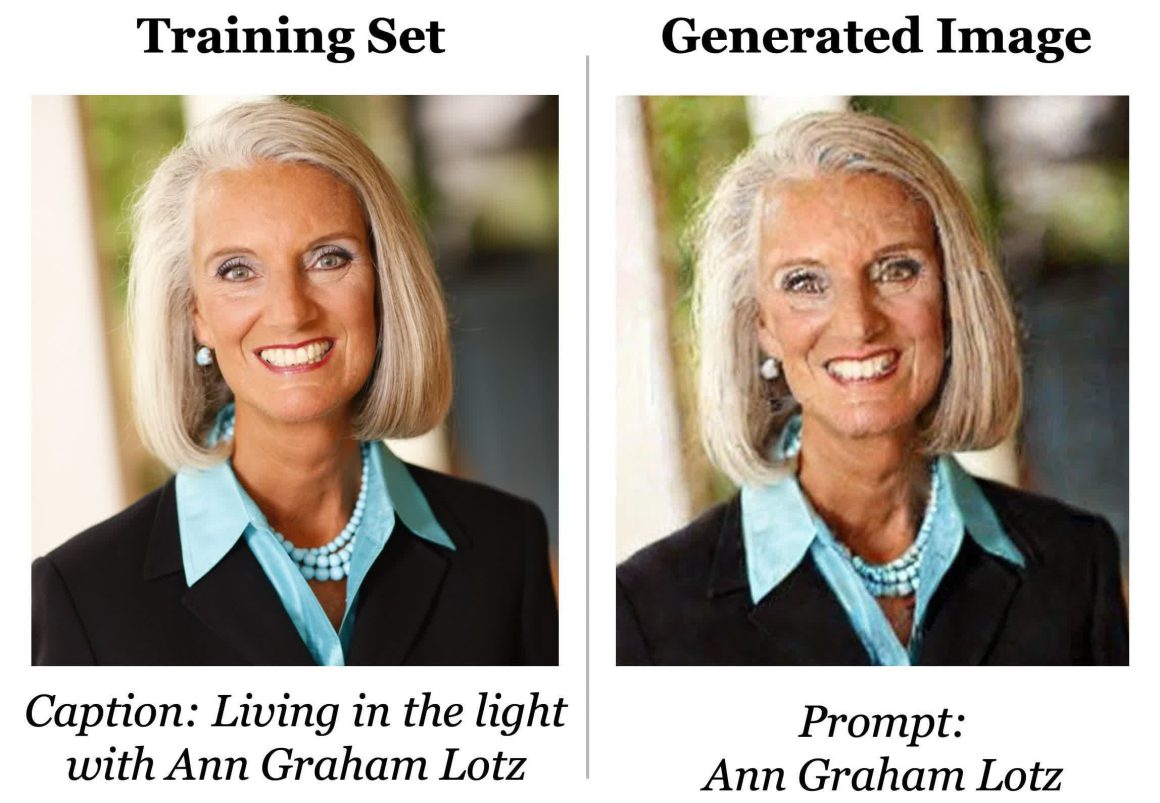

از مجموعه دادههای Stable Diffusion، که شامل مجموعه تصاویر ترابایتی معروف به LAION، برای تولید تصویر زیر استفاده شده است. از عنوان مشخص شده نیز در مجموعه داده استفاده شده است. همانطور که مشاهده میکنید تصاویر کاملا یکسان هستند، اگرچه کمی در اثر نویز دیجیتال فرم خود را از دست داده است. زمانی که محققان عنوان را در اعلان Stable Diffusion وارد کردند، این تصویر تولید شد. در مرحله بعد، تیم پس از اجرای مکرر همان دستور، به صورت دستی تأیید کرد که آیا تصویر بخشی از مجموعه آموزشی است یا خیر.

محققان خاطرنشان کردند که یک درخواست مشابه میتواند در نهایت یک خروجی کاملا مشابه را به همراه داشته باشد، اما ممکن است ترکیب پیکسلی یکسانی وجود نداشته باشد و به این ترتیب هر تصویر آموزشی متفاوت خواهد بود.

دادههای خاص منجر به تولید تصاویر منحصر به فرد میشوند

پروفسور علوم کامپیوتر در ETH زوریخ و فلوریان ترامر، یکی از شرکتکنندگان در این پژوهش، محدودیتهای قابل توجهی را برای یافتهها کشف کرند. عکسهایی که محققان توانستند استخراج کنند، یا به طور مکرر در دادههای آموزشی تکرار میشدند یا به طور قابلتوجهی از بقیه عکسهای مجموعه متمایز بودند. به گفته فلوریان ترامر، کسانی که نامها یا ظاهر نامتعارف دارند، بیشتر به خاطر هوش مصنوعی میمانند.

به گفته محققان، مدلهای هوش مصنوعی قادر به انتشار کمترین نوع از مدل تولید تصویر هستند که در نهایت منجر به تولید تصاویر تکراری و همچنین تصویر افراد واقعی میشود. در مقایسه با شبکههای متخاصم مولد (GAN)، یک کلاس قبل از مدلهای تصویری امروزی، بیش از دو برابر بیشتر از دادههای آموزشی به بیرون درز میکنند. هدف این تحقیق هشدار دادن به توسعهدهندگان در مورد خطرات حریم خصوصی مرتبط با مدلهای انتشاری است که شامل نگرانیهای مختلفی مانند احتمال سوء استفاده و تکرار دادههای خصوصی حساس و دارای کپی رایت، از جمله تصاویر پزشکی، و آسیبپذیری در برابر حملات خارجی در محل آموزش است، زیرا این دادهها را میتوان به راحتی استخراج کرد. راه حلی که محققان پیشنهاد میکنند شناسایی عکسهای تولید شده تکراری در مجموعه آموزشی و حذف آنها از مجموعه دادهها است.

مطالب مرتبط:

دیدگاهتان را بنویسید