ChatGPT، پلتفرم چتبات شرکت OpenAI، ممکن است به اندازهای که پیشتر تصور میشد، پرمصرف نباشد. اما مصرف انرژی بهطور قابلتوجهی به نحوه استفاده از آن و مدلهای هوش مصنوعی که به سؤالات پاسخ میدهند بستگی دارد. این موضوع در یک مطالعه جدید بررسی شده است.

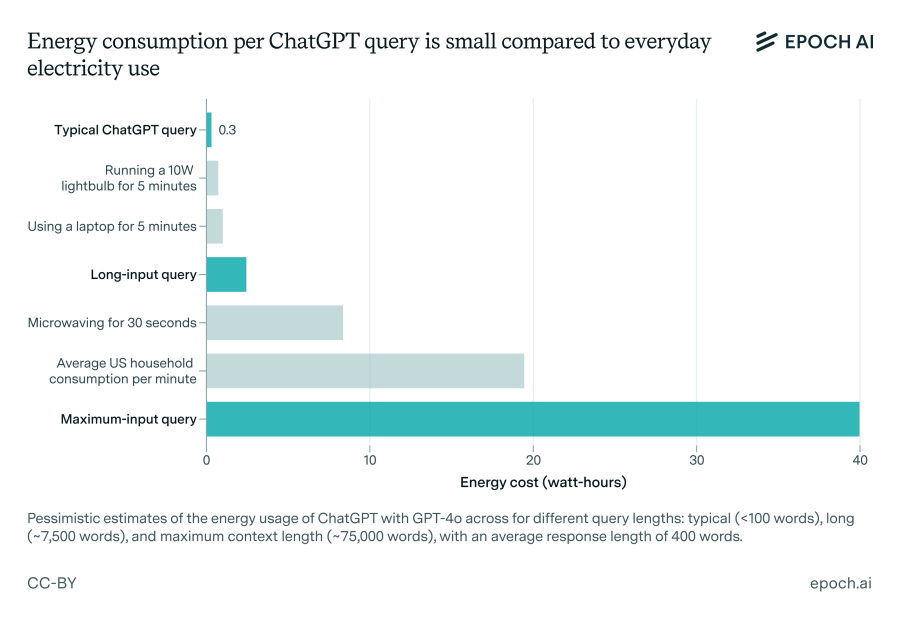

تحلیل اخیر مؤسسه تحقیقاتی غیرانتفاعی Epoch AI تلاش کرده است تا میزان مصرف انرژی یک پرسش معمولی ChatGPT را محاسبه کند. آماری که معمولاً ذکر میشود حاکی از آن است که ChatGPT حدود 3 واتساعت انرژی برای پاسخ به یک پرسش مصرف میکند، یعنی 10 برابر بیشتر از یک جستجوی گوگل.

اما Epoch این عدد را اغراقآمیز میداند. این موسسه با استفاده از مدل پیشفرض جدید OpenAI برای ChatGPT، یعنی GPT-4o، دریافت که هر پرسش ChatGPT به طور میانگین حدود 0.3 واتساعت انرژی مصرف میکند که کمتر از مصرف انرژی بسیاری از لوازم خانگی است.

جاشوا یو، تحلیلگر داده در Epoch که این تحلیل را انجام داده است، گفت: مصرف انرژی ChatGPT در مقایسه با استفاده از لوازم خانگی معمولی یا گرمایش و سرمایش خانه یا رانندگی با خودرو، واقعاً مسئله بزرگی نیست.

مصرف انرژی هوش مصنوعی و تأثیرات زیستمحیطی آن

مصرف انرژی هوش مصنوعی و تأثیرات زیستمحیطی آن موضوعی پرچالش است، بهویژه در زمانی که شرکتهای هوش مصنوعی به دنبال گسترش سریع زیرساختهای خود هستند. تنها در هفته گذشته، گروهی متشکل از بیش از 100 سازمان نامهای سرگشاده منتشر کردند و از صنعت هوش مصنوعی و قانونگذاران خواستند اطمینان حاصل کنند که مراکز داده جدید هوش مصنوعی منابع طبیعی را تخلیه نکنند و شرکتهای خدماتی مجبور به استفاده از منابع انرژی تجدیدناپذیر نشوند.

یو اعلام کرد که این تحلیل با انگیزه تصحیح تحقیقات قدیمی انجام شده است. او توضیح داد که نویسنده گزارشی که عدد 3 واتساعت را تخمین زده بود، فرض کرده بود OpenAI از تراشههای قدیمیتر و کمبازدهتر برای اجرای مدلهای خود استفاده میکند.

او گفت: من بحثهای عمومی زیادی دیدهام که به درستی تشخیص داده بودند هوش مصنوعی انرژی زیادی را در سالهای آینده مصرف میکند، اما بهطور دقیق مصرف کنونی انرژی هوش مصنوعی را توصیف نکردند. همچنین برخی از همکارانم متوجه شدند که تخمین 3 واتساعت برای هر پرسش بر اساس تحقیقات نسبتاً قدیمی بوده و به نظر میرسید اغراقشده باشد.

البته، رقم 0.3 واتساعت ارائهشده توسط Epoch نیز یک تخمین است، زیرا OpenAI جزئیات لازم برای محاسبات دقیق را منتشر نکرده است.

این تحلیل همچنین هزینههای انرژی اضافی ناشی از ویژگیهای خاص ChatGPT مانند تولید تصاویر یا پردازش ورودیها را در نظر نگرفته است. یو اذعان کرد که پرسشهای «ورودی بلند» — مانند پرسشهایی که فایلهای طولانی به آنها ضمیمه میشود — احتمالاً برق بیشتری نسبت به یک پرسش معمولی مصرف میکنند.

او همچنین انتظار دارد مصرف پایه انرژی ChatGPT در آینده افزایش یابد.

یو گفت: هوش مصنوعی پیشرفتهتر خواهد شد، آموزش مدلهای آن احتمالاً انرژی بیشتری خواهد طلبید و در آینده ممکن است به طور گستردهتر و برای وظایف پیچیدهتری نسبت به نحوه استفاده کنونی از ChatGPT استفاده شود.

افزایش مقیاس و مصرف انرژی زیرساختهای هوش مصنوعی

با وجود پیشرفتهای قابلتوجه در بهرهوری هوش مصنوعی در ماههای اخیر، مقیاس استفاده از این فناوری به طور گستردهای باعث گسترش زیرساختهای عظیم و پرمصرف خواهد شد. بر اساس گزارش مؤسسه Rand، در دو سال آینده مراکز داده هوش مصنوعی ممکن است تقریباً به تمام ظرفیت برق کالیفرنیا در سال 2022 (68 گیگاوات) نیاز داشته باشند. همچنین پیشبینی شده است که تا سال 2030 آموزش یک مدل پیشرفته میتواند به توانی معادل هشت رآکتور هستهای (8 گیگاوات) نیاز داشته باشد.

ChatGPT به تنهایی تعداد زیادی از کاربران را در سراسر جهان جذب کرده و به طور مداوم در حال گسترش است، که نیازهای سرور آن را به همان اندازه افزایش میدهد. OpenAI به همراه چندین شریک سرمایهگذاری، برنامهریزی کردهاند که طی چند سال آینده میلیاردها دلار برای پروژههای جدید مراکز داده هوش مصنوعی هزینه کنند.

تمرکز OpenAI — و به طور کلی صنعت هوش مصنوعی — به سمت مدلهای استدلالی معطوف شده است. این مدلها در انجام وظایف توانایی بیشتری دارند، اما برای اجرا به محاسبات بیشتری نیاز دارند. برخلاف مدلهایی مانند GPT-4o که تقریباً بلافاصله به سؤالات پاسخ میدهند، مدلهای استدلالی ممکن است چندین ثانیه یا دقیقه برای پاسخ فکر کنند، که این فرآیند محاسبات — و در نتیجه انرژی بیشتری — را میطلبد.

یو اضافه کرد : مدلهای استدلالی به تدریج وظایفی را انجام میدهند که مدلهای قدیمیتر قادر به انجام آنها نیستند و برای این کار دادههای بیشتری تولید میکنند و هر دو این موارد به مراکز داده بیشتری نیاز دارند.

OpenAI شروع به انتشار مدلهای استدلالی کممصرفتری مانند o3-mini کرده است. اما به نظر نمیرسد دستاوردهای بهرهوری در این مدلها بتواند افزایش نیاز به انرژی برای فرآیند «تفکر» مدلهای استدلالی و رشد استفاده جهانی از هوش مصنوعی را جبران کند.

یو پیشنهاد کرد افرادی که نگران ردپای انرژی هوش مصنوعی خود هستند، از برنامههایی مانند ChatGPT بهطور محدودتری استفاده کنند یا مدلهایی را انتخاب کنند که تا حد امکان نیاز به محاسبات کمتری دارند.

او گفت: میتوانید از مدلهای کوچکتر هوش مصنوعی مانند GPT-4o-mini استفاده کنید و از آنها به شکلی کمک بگیرید که نیازمند پردازش یا تولید دادههای زیاد نباشد.

دیدگاهتان را بنویسید