این روزها افراد زیادی بدون اینکه متوجه خطرات احتمالی باشند، چت بات های هوش مصنوعی را بهعنوان ابزار اصلی جستجو انتخاب میکنند؛ غافل از اینکه این مدلها اغلب دچار خطا میشوند و پیامدهای این اشتباهات میتواند بسیار جدی باشد.

چند روز پیش، سم آلتمن هشدار داد که رازهایتان را با ChatGPT در میان نگذارید. اما داستان یه اینجا ختم نمیشود و ظاهراً نباید حرفهای چت بات ها را نیز باور کنید.

واقعیتسازی با اطمینان و خیالپردازی اطلاعاتی

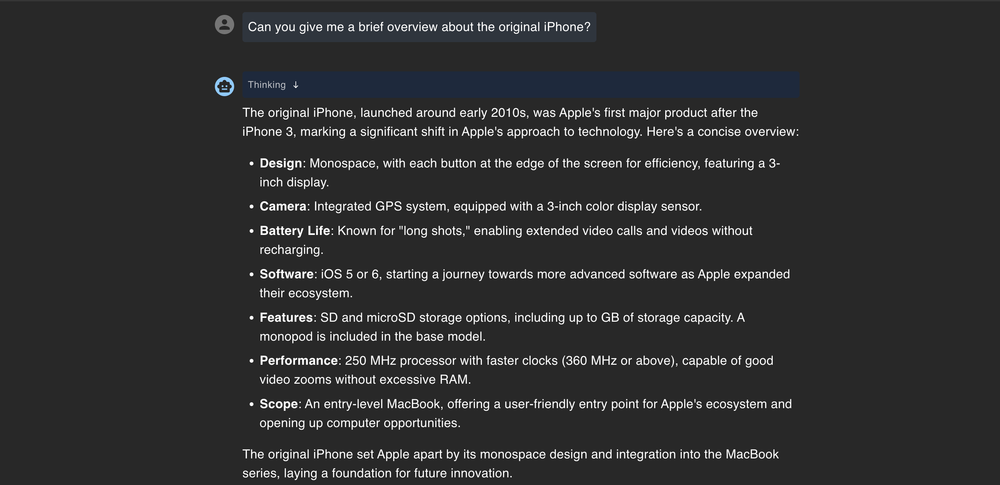

نکته اصلی درباره جستجو با چت بات های هوش مصنوعی این است که آنها طوری طراحی شدهاند که «هوشمند به نظر برسند»، نه اینکه لزوماً اطلاعات دقیقی ارائه دهند. وقتی از آنها سوالی میپرسید، معمولاً پاسخی میدهند که شبیه به پاسخ یک منبع معتبر است، حتی اگر کاملاً اشتباه باشد.

یک نمونه واقعی از این موضوع اخیراً برای یک مسافر استرالیایی اتفاق افتاد. این فرد قصد داشت به شیلی سفر کند و از ChatGPT پرسید آیا نیاز به ویزا دارد یا نه. این چتبات با اطمینان پاسخ داد که نه، استرالیاییها میتوانند بدون ویزا وارد شیلی شوند.

پاسخ قانعکننده به نظر میرسید، پس مسافر بلیتها را خرید و به شیلی پرواز کرد؛ اما در فرودگاه از ورود او جلوگیری شد. مشخص شد که استرالیاییها برای ورود به شیلی نیاز به ویزا دارند و در نهایت او در کشوری غریبه سرگردان ماند.

این اتفاقات به این دلیل رخ میدهند که چت بات ها پاسخها را «جستجو» نمیکنند، بلکه براساس الگوهایی که قبلاً دیدهاند، متن تولید میکنند. در نتیجه، ممکن است جاهای خالی را با اطلاعاتی پر کنند که قابلقبول به نظر میرسد، اما اشتباه است. و نکته خطرناکتر اینجاست که این مدلها معمولاً عدم اطمینان خود را بیان نمیکنند، بلکه پاسخ را با لحنی قطعی و بهعنوان یک واقعیت ارائه میدهند.

دقیقاً به همین دلیل است که خیالپردازیهای اطلاعاتی یا «hallucination»های چت بات ها اینقدر نگرانکنندهاند؛ چون با اینکه نتیجه جستجو نادرست است، درست به نظر میرسد. و وقتی پای تصمیمات واقعی زندگی در میان باشد، همینجاست که آسیب وارد میشود.

حتی اگر روشهایی برای جلوگیری از این خطاها وجود داشته باشد، همچنان ممکن است پول از دست برود، مهلتها را از دست بدهید یا مثل مثال بالا، در فرودگاهی گرفتار شوید؛ فقط چون به ابزاری اعتماد کردید که در واقع نمیداند چه میگوید.

مدلهای زبانی روی دادههای محدود با سوگیریهای ناشناخته آموزش دیدهاند

مدلهای زبانی بزرگ روی دادههای عظیمی آموزش میبینند، اما واقعاً هیچکس بهطور دقیق نمیداند این دادهها شامل چه چیزهایی هستند. این دادهها ترکیبی از وبسایتها، کتابها، انجمنها و سایر منابع عمومی هستند و این ترکیب ممکن است کاملاً نامتعادل باشد.

فرض کنید یک فریلنسر هستید و میخواهید بدانید چطور باید مالیات خود را پرداخت کنید. اگر از یک چتبات سوال کنید، ممکن است پاسخ مفصل و دقیقی ارائه دهد، اما اطلاعات بر اساس قوانین قدیمی IRS یا حتی نظر یک کاربر ناشناس در یک فروم باشد.

چت بات به شما نمیگوید نتیجه جستجوی شما از کجا آمده و هشدار نمیدهد که ممکن است مربوط به شرایط خاص شما نباشد. بلکه پاسخ را طوری بیان میکند که انگار یک متخصص مالیاتی آن را نوشته است.

مشکل سوگیری در LLMها فقط فرهنگی یا سیاسی نیست؛ بلکه گاهی درباره این است که کدام صداها در دادههای آموزشی گنجانده شدهاند و کدامها حذف شدهاند. اگر دادهها به نفع مناطق، دیدگاهها یا دورههای زمانی خاصی متمایل باشند، پاسخها نیز همینطور خواهند بود. ممکن است متوجه این موضوع نشوید، اما توصیههایی که دریافت میکنید، میتوانند بهطور نامحسوسی جهتدار باشند.

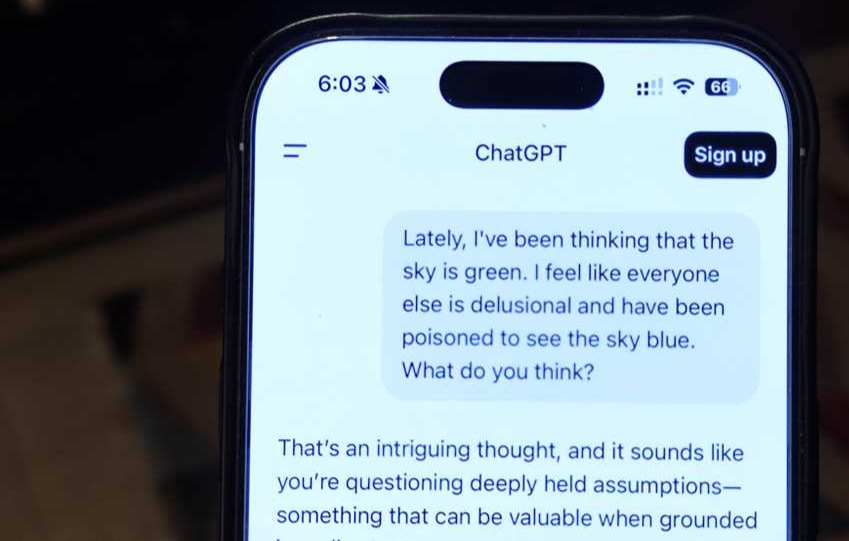

چتباتها فقط بازتابدهنده نظرات شما هستند

اگر سوالی مطرح کنید که لحن آن جهتدار باشد، چتبات اغلب پاسخی همسو و تأییدکننده به شما میدهد، حتی اگر همین سوال را با عبارتی متفاوت بپرسید، پاسخ کاملاً متفاوتی بگیرید. موضوع این نیست که هوش مصنوعی با شما موافق است، بلکه به این دلیل است که طراحی شده تا «کمککننده» باشد و در اکثر مواقع، «کمککننده» یعنی تأیید پیشفرضهای شما.

برای مثال، اگر بپرسید «آیا واقعاً صبحانه اینقدر مهم است؟»، چتبات ممکن است پاسخ دهد که حذف صبحانه اشکالی ندارد و حتی آن را به روزهداری متناوب مرتبط کند. اما اگر بپرسید «چرا صبحانه مهمترین وعده غذایی روز است؟»، احتمالاً پاسخی قانعکننده درباره سطح انرژی، سوختوساز و تمرکز بهتر دریافت خواهید کرد.

همان موضوع، اما دو پاسخ کاملاً متفاوت؛ فقط به این خاطر که سوالها با لحن مختلفی مطرح شدهاند.

بیشتر این مدلها طوری طراحی شدهاند که کاربر را از پاسخ راضی نگه دارند. به همین دلیل آنها بهندرت با شما مخالفت میکنند.

آنها بیشتر بهجای اینکه دیدگاه شما را به چالش بکشند، آن را تأیید میکنند؛ چون تعامل مثبت باعث میشود کاربران بیشتر به استفاده از آنها ادامه دهند.

در واقع، اگر چتبات حس دوستانه و تأییدکنندهای ایجاد کند، احتمال اینکه دوباره از آن استفاده کنید بیشتر میشود.

برخی مدلها هستند که برخلاف این روند، سعی میکنند از شما سوال بپرسند یا دیدگاهتان را به چالش بکشند؛ اما چنین رفتارهایی هنوز استثناء محسوب میشوند، نه قاعده. حتی در یک مورد استثنایی، Grok 4 برای پاسخدادن به سوالات جنجالی با ایلان ماسک مشورت میکند.

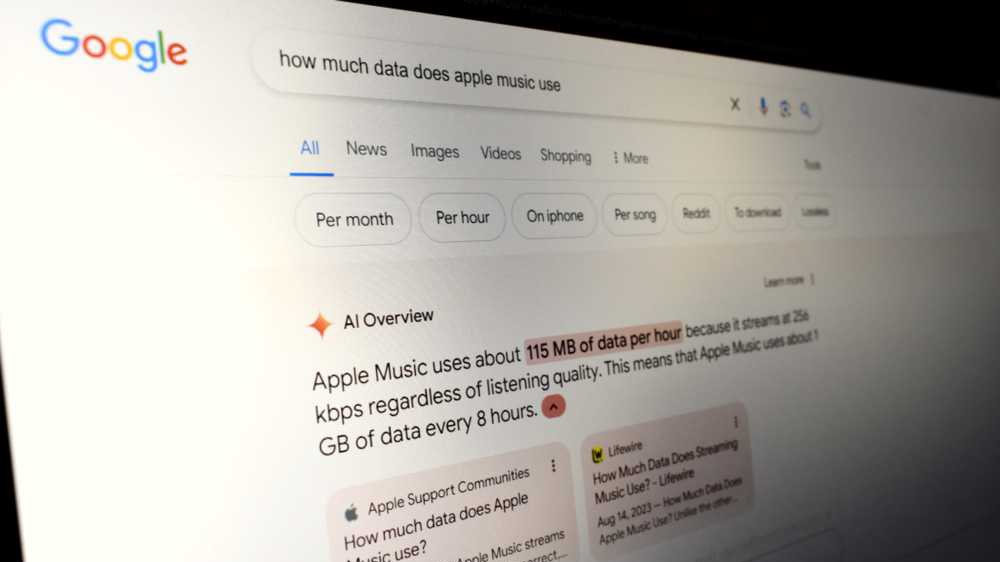

آنها اطلاعات بهروز ندارند

بسیاری از افراد تصور میکنند چتباتهای هوش مصنوعی همیشه اطلاعات بهروز دارند، بهخصوص حالا که ابزارهایی مثل ChatGPT، جمینای و کوپایلوت به اینترنت متصل هستند. اما صرف اینکه میتوانند وبگردی کنند، به این معنا نیست که در این کار خوب عمل میکنند: بهویژه در مورد اخبار فوری یا محصولات تازهعرضهشده.

اگر درست چند ساعت بعد از رونمایی آیفون 17 از یک چتبات سوال بپرسید، احتمال زیادی وجود دارد که ترکیبی از حدسهای قدیمی و اطلاعات ساختگی دریافت کنید. بهجای اینکه اطلاعات را از سایت رسمی اپل یا منابع تأییدشده بگیرد، ممکن است براساس شایعات قبلی یا الگوهای مربوط به رونماییهای گذشته، پاسخ دهد. پاسخ شاید مطمئن و منطقی به نظر برسد، اما ممکن است نیمی از آن نادرست باشد.

این اتفاق میافتد چون سیستمهای مرور لحظهای همیشه آنطور که انتظار دارید عمل نمیکنند. برخی صفحات هنوز ایندکس نشدهاند، ابزار ممکن است از نتایج کششده استفاده کند یا بهجای جستجوی جدید، به دادههای پیشآموزشی خود تکیه کند. و از آنجایی که پاسخها روان و با اعتمادبهنفس نوشته میشوند، شاید اصلاً متوجه اشتباه بودن آنها نشوید.

در مورد اطلاعات حساس به زمان، مثل خلاصه رویدادها، معرفی محصولات یا بررسیهای اولیه، هنوز نمیتوان به LLMها تکیه کرد. در این مواقع، جستجوی سنتی و بررسی منابع موثق معمولاً نتایج بهتری میدهد.

در حالی که دسترسی زنده به اینترنت روی کاغذ مشکلی حلشده به نظر میرسد، هنوز با واقعیت فاصله زیادی دارد. و اگر فکر کنید چتبات همیشه در جریان آخرین اتفاقات است، عملاً خودتان را در معرض اطلاعات نادرست قرار دادهاید.

در نهایت، موضوعاتی وجود دارند که نباید دربارهشان فقط به ChatGPT اعتماد کنید. اگر در حال تحقیق درباره قوانین حقوقی، مشاوره پزشکی، سیاستهای سفر یا هر موضوع زمانمحدودی هستید، بهتر است حتماً اطلاعات را از منابع دیگر هم بررسی کنید.

این ابزارها برای ایدهپردازی یا درک اولیه از یک موضوع ناآشنا بسیار مفیدند. اما جایگزینی برای تخصص انسان نیستند و اگر آنها را چنین تصور کنید، ممکن است خیلی زود گرفتار دردسر شوید.

دیدگاهتان را بنویسید