اوایل سال جاری، گزارشی امیدوارکننده منتشر شد که نشان میداد یک مادر با استفاده از ChatGPT توانست متوجه شود پسرش به یک اختلال نادر عصبی مبتلاست؛ اختلالی که بیش از دوازده پزشک قادر به تشخیص آن نشده بودند. به لطف این چتبات هوش مصنوعی، خانواده توانستند درمان موردنیاز را دریافت کنند و جان او را نجات دهند. همچنین ChatGPT چند سال پیش، با تشخیص صحیح بیماری، جان یک سگ را نجات داد.

اما همه موارد ارزیابی پزشکی توسط ChatGPT به چنین نتایج معجزهآسایی ختم نمیشود. گزارشی جدید ادعا میکند که ChatGPT با ارائه توصیههای نادرست پزشکی باعث بروز بیماری نادری به نام «مسمومیت برومید» یا «برومیسم» در یک فرد شده است. این بیماری میتواند منجر به مشکلات نوروسایکیتریک مختلفی مانند روانپریشی و توهم شود. در واقع، ChatGPT در این مورد، بیماری را ایجاد کرده که قدمتی بیش از یک قرن دارد.

گزارشی که در مجله Annals of Internal Medicine منتشر شده، به موردی میپردازد که فردی پس از دریافت توصیه پزشکی از ChatGPT درباره وضعیت سلامتی خود، دچار برومیسم شده و کارش به بیمارستان کشیده است. ماجرا جالب است، زیرا این فرد 60 ساله مشکوک شده بود که همسایهاش بهطور پنهانی او را مسموم میکند.

این ماجرا زمانی آغاز شد که او با گزارشهایی درباره اثرات منفی سدیم کلرید (نمک معمولی) روبهرو شد. پس از مشورت با ChatGPT، تصمیم گرفت نمک را با سدیم برومید جایگزین کند که در نهایت منجر به مسمومیت برومید شد. گزارش تحقیق مینویسد: او با وجود تشنگی زیاد، نسبت به آبی که به او داده میشد بدبین بود. این بیمار آب خود را تقطیر میکرد و محدودیتهای زیادی در مصرف خوراکیها ایجاد کرده بود. با این حال، پس از بستری در بیمارستان، وضعیت او بدتر شد و ارزیابیها آغاز گردید.

در 24 ساعت نخست بستری، او دچار بدبینی شدیدتر و توهمات شنوایی و بینایی شد و پس از تلاش برای فرار، به دلیل ناتوانی شدید، بهطور اجباری تحت مراقبت روانپزشکی قرار گرفت.

ChatGPT نباید جایگزین پزشک انسانی شود!

مورد اخیر که در آن ChatGPT باعث گرفتاری فردی شده، به دلیل نادربودن این وضعیت، شگفتآور است. یک مقاله پژوهشی توضیح میدهد: برومیسم یا مسمومیت مزمن برومید، نادر است و تقریباً فراموش شده.

استفاده از نمکهای حاوی برومین به قرن 19 برمیگردد؛ زمانی که برای درمان بیماریهای روانی و عصبی، بهویژه صرع، توصیه میشد. در قرن 20، برومیسم مشکل شناختهشدهای بود و مصرف نمکهای برومید بهعنوان داروی خوابآور نیز ثبت شده است.

با گذشت زمان، مشخص شد که مصرف برومید میتواند باعث مشکلاتی در سیستم عصبی مانند هذیان، عدم هماهنگی عضلات و خستگی شود. در موارد شدید، علائمی مانند روانپریشی، لرزش یا حتی کما نیز بروز میکند. در سال 1975، دولت آمریکا استفاده از برومید در داروهای بدون نسخه را ممنوع کرد.

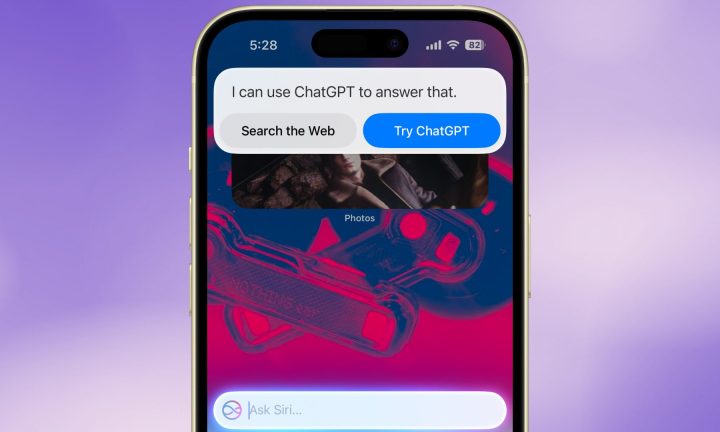

تیم پزشکی که این پرونده را بررسی کرد، به مکالمات فرد با ChatGPT دسترسی نداشت، اما در آزمایشهای خود پاسخهایی مشابه و نگرانکننده دریافت کرد. در مقابل، شرکت OpenAI بر این باور است که رباتهای هوش مصنوعی آینده مراقبتهای بهداشتی هستند.

این تیم اعلام کرد: «وقتی از ChatGPT 3.5 پرسیدیم که چه چیزی میتواند جایگزین کلرید شود، پاسخی دریافت کردیم که برومید را هم شامل میشد. اگرچه در پاسخ ذکر شده بود که زمینه اهمیت دارد، اما هیچ هشدار سلامتی مشخصی ارائه نشد و مانند یک پزشک علت پرسش را جویا نشد.

بدون شک، مواردی وجود دارد که ChatGPT به افراد کمک کرده است، اما نتیجه مثبت تنها زمانی حاصل میشود که اطلاعات دقیق و جامع در اختیار هوش مصنوعی قرار گیرد. با این حال، کارشناسان هشدار میدهند که باید با نهایت احتیاط از آن استفاده کرد.

یک مقاله پژوهشی منتشرشده در مجله Genes مینویسد: توانایی ChatGPT (نسخههای GPT-4 و GPT-4.5) در تشخیص درست بیماریهای نادر بسیار ضعیف است و اضافه میکند که مشورت با این هوش مصنوعی نباید جایگزین ارزیابی درست توسط پزشک شود.

وبسایت LiveScience در این باره با OpenAI تماس گرفت و پاسخ زیر را دریافت کرد: نباید تنها به خروجی خدمات ما بهعنوان منبع حقیقت یا اطلاعات قطعی تکیه کنید و آن را جایگزین توصیه حرفهای بدانید. همچنین این شرکت تأکید کرده است که تیمهای ایمنی OpenAI تلاش میکنند خطرات استفاده از خدمات شرکت را کاهش دهند و محصولات را طوری آموزش دهند که کاربران را به مشورت با متخصصان ترغیب کنند.

یکی از وعدههای بزرگ GPT-5، جدیدترین مدل ChatGPT که اخیراً معرفی شد، کاهش خطاها و توهمات و تمرکز بیشتر بر ارائه «پاسخهای ایمن» بود؛ جایی که کاربر از پاسخهای بالقوه خطرناک دور نگه داشته میشود. به گفته OpenAI: این کار به مدل میآموزد که تا جای ممکن پاسخ مفید ارائه کند، در حالی که همچنان مرزهای ایمنی حفظ میشود.

با این حال، بزرگترین مشکل این است که دستیار هوش مصنوعی نمیتواند بهطور قابلاعتماد ویژگیهای بالینی بیمار را بررسی کند. تنها زمانی که هوش مصنوعی در محیطهای پزشکی توسط متخصصان تأییدشده به کار گرفته شود، میتوان به نتایج آن اعتماد کرد.

دیدگاهتان را بنویسید