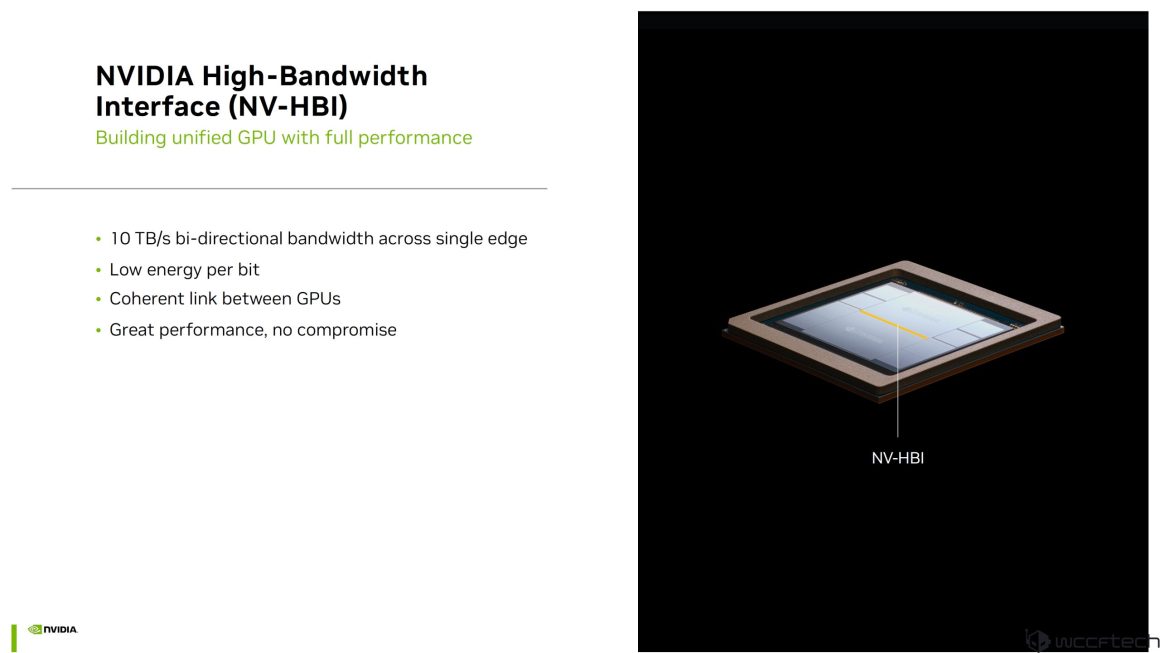

به تازگی جزئیات پلتفرم Blackwell انویدیا منتشر شده و پهنای باند جدیدی به نام NV-HBI برای اتصال دو کارت گرافیک همزمان معرفی شده است.

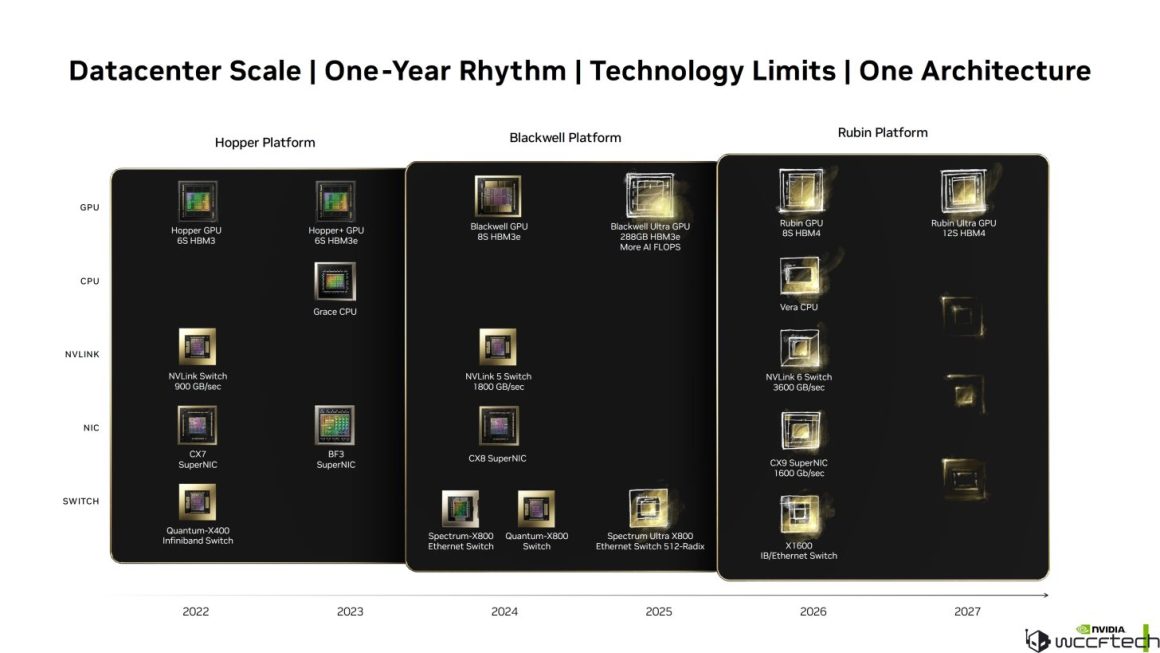

هفته گذشته، انویدیا اعلام کرد که اطلاعات بیشتری درمورد پلتفرم بلکول هوش مصنوعی خود ارائه خواهد داد و اولین تصاویر از بلکول را در حال کار در دیتاسنترها به نمایش گذاشت. امروز، این شرکت جزئیات جدیدی در مورد کل پلتفرم بلکول ارائه کرد که تنها شامل یک چیپ نمیشود بلکه از چندین محصول مختلف تشکیل شده است.

کل پلتفرم بلکول انویدیا با بیش از 400 کتابخانه “بهینهسازی شده” CUDA-X که حداکثر عملکرد را بر روی چیپهای بلکول ارائه میدهند، قدرت میگیرد. این کتابخانهها برای حوزههای مختلف کاربردی طراحی شدهاند و بر روی نوآوریهای دههای ساخته شدهاند که در بسته CUDA-X جمعآوری شدهاند. این کتابخانه از الگوریتمهای در حال گسترش پشتیبانی میکند و آن را برای نسل بعدی مدلهای هوش مصنوعی آیندهنگر میسازد.

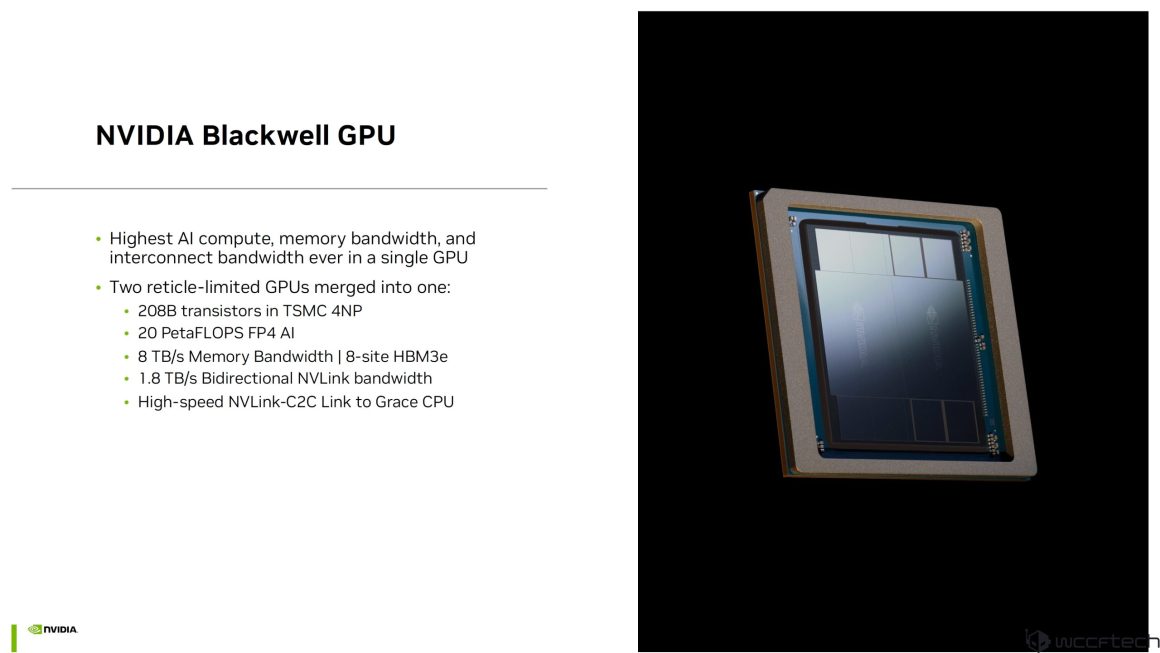

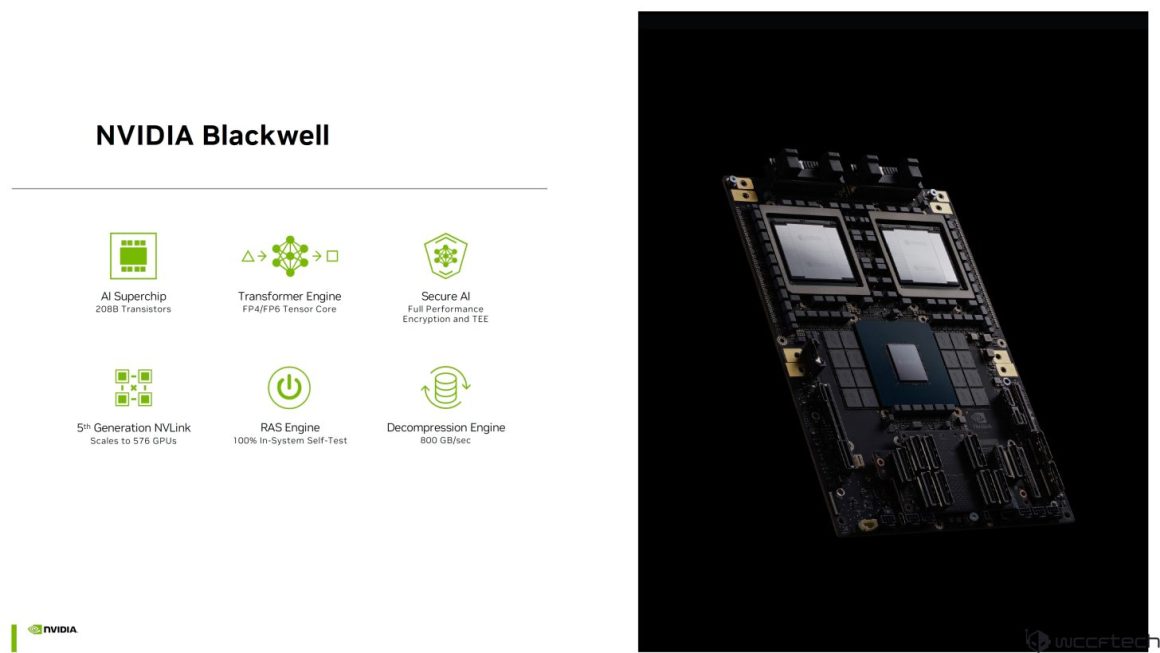

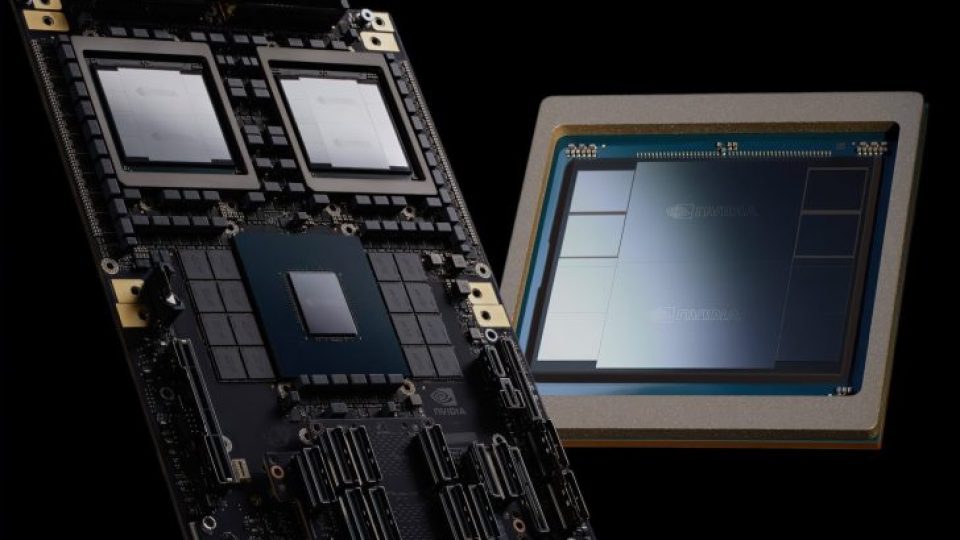

پردازنده گرافیکی بلکول انویدیا دارای بالاترین سطح محاسبات هوش مصنوعی، پهنای باند حافظه و پهنای باند ارتباطی در یک کارت گرافیک واحد است. این کارت گرافیک از دو پردازنده گرافیکی با محدوده رتیکل که با استفاده از NV-HBI به هم متصل شدهاند، تشکیل شده است. خود چیپ دارای 208 میلیارد ترانزیستور است که در فرآیند TSMC 4NP و در یک طراحی بیش از 1600 میلیمتر مربع ساخته شده است. کارت گرافیک هوش مصنوعی بلکول 20 پتافلاپ عملکرد FP4 هوش مصنوعی، 8 ترابایت بر ثانیه پهنای باند حافظه (8 سایت بر روی HBM3e)، 1.8 ترابایت بر ثانیه پهنای باند NVLINK دوطرفه و یک لینک پرسرعت NVLINK-C2C به CPU گریس ارائه میدهد.

معماری کارت گرافیک بلکول همچنین با معماری هسته تنسور نسل 5 تقویت شده است که دارای فرمتهای دادهای جدیدی مانند FP4، FP6 و FP8 است. این فرمتهای میکرو تنسور به بردارهای با طول ثابت اعمال میشوند، اجازه میدهند که عناصر به فاکتورهای مقیاسی که ثابت هستند نگاشت شوند و پهنای باند گستردهتری، مصرف توان کمتر و دقت بیشتری را ارائه دهند.

نگاهی به تأثیرات عملکرد هستههای تنسور نسل 5 نشان میدهد که هر یک از فرمتهای داده موجود (FP16، BF16، FP8) در هر کلاک دو برابر سرعت بیشتری نسبت به Hopper دارند، در حالی که FP6 دو برابر سرعت بیشتری نسبت به FP8 Hopper دارد و FP4 چهار برابر سرعت بیشتری نسبت به FP8 Hopper دارد. علاوه بر فرمتهای جدید، کارت گرافیکهای بلکول هوش مصنوعی همچنین دارای فرکانسهای عملیاتی افزایش یافته نسبت به چیپهای Hopper هستند.

یکی از ویژگیهای جدید برای بلکول، سیستم کوانتش Quasar انویدیا است که فرمتهای کمدقت مانند FP4 را به دادههای با دقت بالا تبدیل میکند، با استفاده از کتابخانههای بهینهسازی شده، موتورهای مبدل سختافزار و نرمافزار و الگوریتمهای عددی کمدقت، در مقایسه با BF16، FP4 کوانتش شده همان امتیاز MMLU را در مدلهای LLM و همان دقت را در مدلهای Nemotron-4 15B و حتی 340B ارائه میدهد.

پلتفرم بلکول انویدیا مجموعهای از چیپها، سیستمها و نرمافزارهای CUDA انویدیا را به هم میآورد تا نسل بعدی هوش مصنوعی را در کاربردها، صنایع و حل مسائل پیچیده تقویت کند. انویدیا GB200 NVL72 یک راهحل چند نودی، مایع خنک، در مقیاس رک که 72 GPU بلکول و 36 CPU گریس را به هم متصل میکند، مرزهای طراحی سیستمهای هوش مصنوعی را بالا میبرد. فناوری ارتباطی NVLink ارتباط همه به همه کارت گرافیک را فراهم میکند و توان عبور و تأخیر پایین را برای ارزیابی هوش مصنوعی مولد ارائه میدهد. سیستم کوانتش Quasar انویدیا، مرزهای فیزیک را برای تسریع محاسبات هوش مصنوعی جابهجا میکند. پژوهشگران انویدیا در حال ساخت مدلهای هوش مصنوعی هستند که به ساخت پردازندههایی برای هوش مصنوعی کمک میکنند.

یکی دیگر از جنبههای بزرگ پلتفرم هوش مصنوعی بلکول انویدیا، نسل 5 NVLINK است که کل پلتفرم را با استفاده از 18 NVLINK با پهنای باند 100 گیگابایت بر ثانیه برای هر کدام، یعنی پهنای باند 1.8 ترابایت بر ثانیه، متصل میکند.

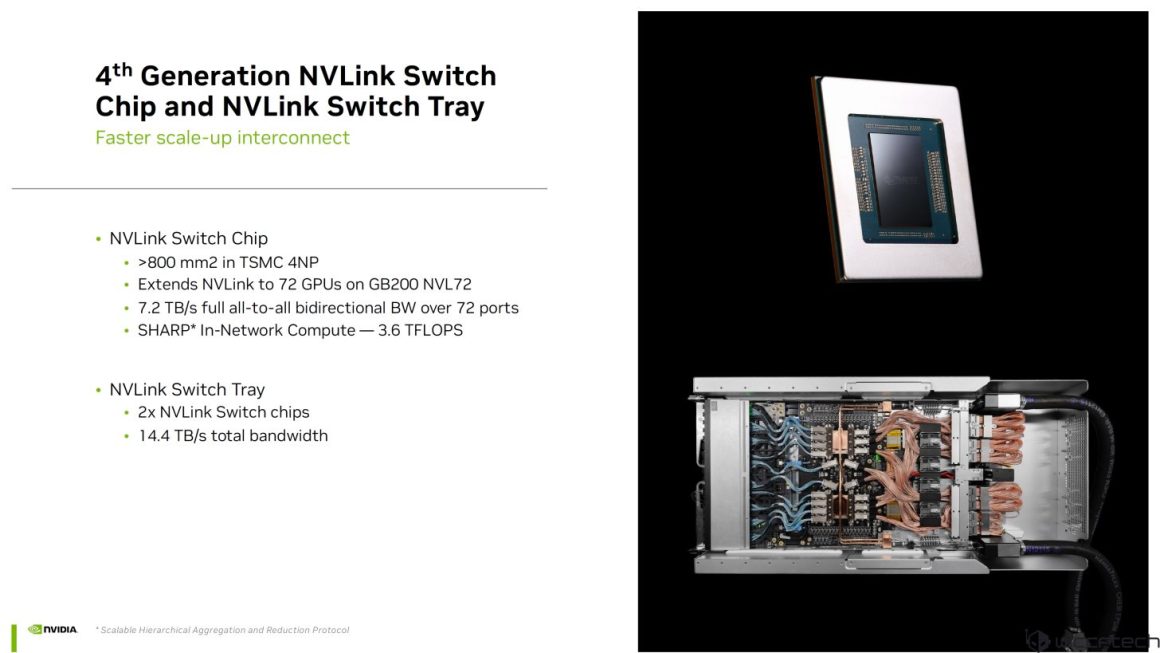

همچنین یک چیپ سوئیچ NVLINK نسل 4 وجود دارد که درون سینی سوئیچ NVLINK قرار دارد و دارای اندازه چیپ بیش از 800 میلیمتر مربع (TSMC 4NP) است. این چیپها NVLINK را به 72 GPU در رکهای GB200 NVL72 گسترش میدهند و پهنای باند همه به همه دوطرفه 7.2 ترابایت بر ثانیه را از طریق 72 پورت و محاسبات درون شبکه SHARP با 3.6 ترافلاپس ارائه میدهند. سینی دارای دو سوئیچ با پهنای باند ترکیبی 14.4 ترابایت بر ثانیه است.

همه اینها در NVIDIA GB200 Grace Blackwell Superchip، یک توان محاسباتی هوش مصنوعی با 1 CPU گریس و 2 GPU بلکول (چهار قالب GPU)، جمع میشود. برد دارای ارتباط NVLINK-C2C است و 40 پتافلاپ FP4 و 20 پتافلاپ محاسبه FP8 را ارائه میدهد. یک سینی Grace Blackwell با 2 CPU گریس (هر کدام 72 هسته) و 4 GPU بلکول (8 قالب GPU) همراه است.

NVLINK Spine سپس در سرورهای GB200 NVL72 و NVL36 استفاده میشود که تا 36 CPU گریس، 72 GPU بلکول، و همه کاملاً متصل با استفاده از رک سوئیچ NVLINK را ارائه میدهند. این سرور 720 پتافلاپ آموزش، 1440 پتافلاپ ارزیابی، پشتیبانی از مدلهایی با حداکثر 27 تریلیون پارامتر و پهنای باند تا 130 ترابایت بر ثانیه (چند نودی) را ارائه میدهد.

در نهایت، Spectrum-X وجود دارد که اولین پارچه اترنت ساخته شده برای هوش مصنوعی در جهان است و شامل دو چیپ، Spectrum-4 با 100 میلیارد ترانزیستور، پهنای باند 51.2T، 64 پورت 800G و 128 پورت 400G و Bluefield-3 DPU با 16 هسته Arm A78، 256 رشته و اترنت 400 گیگابیت بر ثانیه است. این دو چیپ اترنت هوش مصنوعی در رک Spectrum-X800 به هم میپیوندند که یک پلتفرم بی نهایت برای بارهای کاری هوش مصنوعی ابری است.

ترکیب پلتفرم هوش مصنوعی بلکول انویدیا یک افزایش 30 برابری در حال ارزیابی نسبت به Hopper و در عین حال افزایش 25 برابری در بهرهوری انرژی را ارائه میدهد. اما انویدیا تازه شروع کرده است، پس از بلکول، تیم سبز همچنین قصد دارد Blackwell Ultra را با افزایش چگالی محاسبات و حافظه در سال 2025 عرضه کند و سپس Rubin و Rubin Ultra با HBM4 و معماریهای جدید را در سالهای 2026-2027 معرفی کند. کل اکوسیستم CPU، شبکه و ارتباط نیز طی سالهای 2025-2027 بهروزرسانیهای عمدهای دریافت خواهد کرد.

مطالب مرتبط:

دیدگاهتان را بنویسید