گوگل اعلام کرده که خانواده جدید مدلهای هوش مصنوعی آن، تحت عنوان PaliGemma 2، یک ویژگی جالب دارند: توانایی شناسایی احساسات.

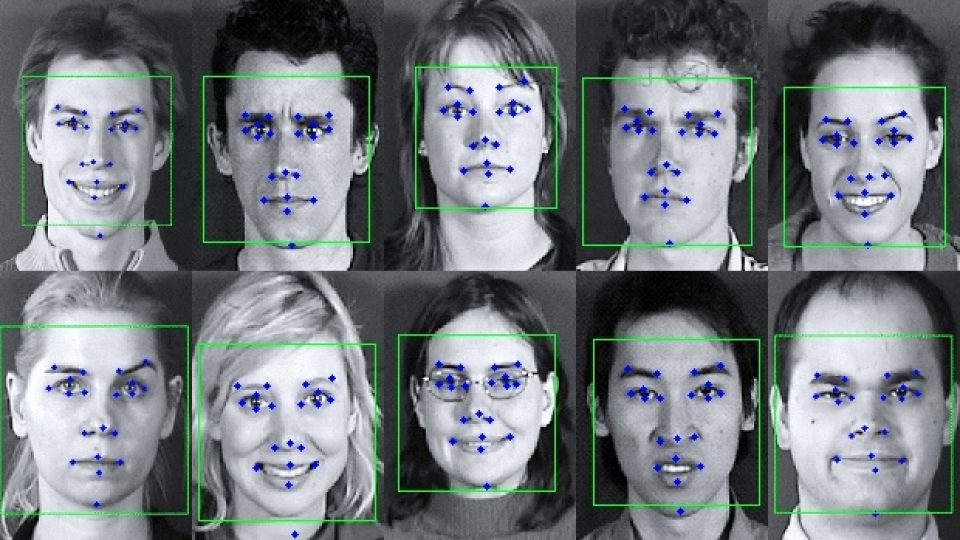

این مدلها که روز پنجشنبه معرفی شدند، قادرند تصاویر را تحلیل کنند و به هوش مصنوعی امکان دهند کپشنهای توضیحی تولید کند و به سوالات مربوط به افرادی که در عکسها میبیند، پاسخ دهد.

گوگل در یک پست وبلاگی نوشت: PaliGemma 2 کپشنهای دقیق و متناسب با زمینه برای تصاویر تولید میکند که فراتر از شناسایی ساده اشیاء است و شامل توصیف اعمال، احساسات و روایت کلی صحنه میشود.

نگرانیهای مربوط به قابلیت شناسایی احساسات مدلهای هوش مصنوعی گوگل

تشخیص احساسات بهطور پیشفرض در این مدل فعال نیست و برای انجام این کار باید مدل PaliGemma 2 تنظیم شود. با این حال، کارشناسان نگران این قابلیت هستند.

ساندرا واچتر، استاد اخلاق داده و هوش مصنوعی در موسسه اینترنت آکسفورد، گفت: قابلیت شناسایی احساسات مدلهای هوش مصنوعی گوگل برای من بسیار نگرانکننده است. به نظرم فرض اینکه میتوانیم احساسات افراد را بخوانیم، مسئلهساز است. این کار شبیه این است که از یک گوی پیشگویی (Magic 8 Ball) برای مشورتگرفتن استفاده کنیم.

برای سالها، استارتاپها و غولهای فناوری تلاش کردهاند هوش مصنوعیای بسازند که بتواند احساسات را شناسایی کند، از آموزش فروش گرفته تا پیشگیری از حوادث. برخی ادعا میکنند که به این هدف رسیدهاند، اما علم پشت این ادعاها پایههای تجربی محکمی ندارد.

مبانی علمی مورد تردید

بیشتر سیستمهای تشخیص احساسات براساس کارهای اولیه پاول اکمن، روانشناسی که نظریهپردازی کرد انسانها شش احساس بنیادین مشترک دارند (خشم، شگفتی، انزجار، لذت، ترس و غم) توسعه یافتهاند. اما تحقیقات بعدی این نظریه را زیر سوال بردند و نشان دادند که تفاوتهای زیادی در نحوه ابراز احساسات افراد از فرهنگها و پیشینههای مختلف وجود دارد.

مایک کوک، پژوهشگر متخصص در هوش مصنوعی از دانشگاه کوئین مری گفت: تشخیص احساسات در حالت کلی امکانپذیر نیست، زیرا افراد به شیوههای پیچیدهای احساسات را تجربه میکنند. البته ممکن است فکر کنیم میتوانیم با نگاه به دیگران بفهمیم چه احساسی دارند، و در طول سالها بسیاری این کار را امتحان کردهاند؛ ازجمله آژانسهای جاسوسی یا شرکتهای بازاریابی. مطمئنم که میتوان نشانههای کلی را در برخی موارد شناسایی کرد، اما این مسئله چیزی نیست که بتوان بهطور کامل آن را حل کرد.

تعصبات و نتایج غیرقابلاعتماد

نتیجه قابل پیشبینی این است که سیستمهای تشخیص احساسات تمایل دارند غیرقابل اعتماد بودن و به فرضیات طراحان خود متکی باشند. در یک مطالعه سال 2020 در MIT، پژوهشگران نشان دادند که مدلهای تحلیل چهره ممکن است بهطور ناخواسته ترجیحات خاصی را برای برخی حالات، مانند لبخندزدن، ایجاد کنند. تحقیقات جدیدتر نشان میدهد که مدلهای تحلیل احساسات چهرههای افراد سیاهپوست را بیشتر از چهرههای سفیدپوست به احساسات منفی نسبت میدهند.

گوگل میگوید آزمایشهای گستردهای برای ارزیابی تعصبات دموگرافیک در مدل PaliGemma 2 انجام داده و به سطوح پایین «سمیت و توهین» در مقایسه با معیارهای صنعتی رسیده است. با این حال، این شرکت فهرست کامل معیارهای استفادهشده یا جزئیات آزمایشها را ارائه نکرده است.

تنها معیاری که گوگل فاش کرده، FairFace است، مجموعهای از دهها هزار عکس سر افراد. گوگل ادعا میکند که PaliGemma 2 در FairFace عملکرد خوبی داشته است. اما برخی پژوهشگران از این معیار بهعنوان شاخصی برای سنجش تعصب انتقاد کردهاند، زیرا FairFace تنها چند گروه نژادی محدود را نمایندگی میکند.

انتقادات و خطرات

هیدی خلاف، دانشمند ارشد هوش مصنوعی در موسسه غیرانتفاعی AI Now در این زمینه گفت: تفسیر احساسات موضوعی بسیار ذهنی بوده که فراتر از استفاده از ابزارهای بصری است و به شدت در زمینههای شخصی و فرهنگی ریشه دارد. تحقیقات نشان داده است که نمیتوان احساسات را تنها از ویژگیهای صورت استنباط کرد.

سیستمهای تشخیص احساسات اعتراض ناظران خارج از کشور را برانگیختهاند. اتحادیه اروپا در قانونگذاری اصلی خود در زمینه هوش مصنوعی، استفاده از این فناوری در مدارس و محل کار را ممنوع کرده است (اما این محدودیت شامل آژانسهای اجرای قانون نمیشود).

بزرگترین نگرانی در مورد مدلهای باز مانند PaliGemma 2، که از طریق پلتفرمهای مختلف از جمله Hugging Face دردسترس هستند، این است که احتمال دارد سوءاستفاده یا استفاده نادرستی از آنها صورت گیرد که میتواند به آسیبهای واقعی در دنیای واقعی منجر شود.

خلاف گفت: اگر این بهاصطلاح شناسایی احساسات بر پایه فرضیات شبهعلمی باشد، پیامدهای مهمی در نحوه استفاده از این قابلیت بهوجود میآید که میتواند به تبعیض ناعادلانه علیه گروههای حاشیهنشین منجر شود؛ مثلاً در نیروی انتظامی، استخدام نیروی انسانی، یا مدیریت مرزها.

در پاسخ به سوال درباره خطرات انتشار عمومی PaliGemma 2، سخنگوی گوگل گفت این شرکت پشت نتایج آزمایشهای خود برای آسیبهای نمایشی مرتبط با پاسخگویی بصری و تولید کپشن میایستد. وی افزود: ما ارزیابیهای قویای از مدلهای PaliGemma 2 از نظر اخلاق و ایمنی، از جمله ایمنی کودکان و محتوای ایمن، انجام دادهایم.

با این حال، واچتر قانع نشده که این اقدامات کافی باشد. او میگوید: نوآوری مسئولانه یعنی از همان روز اولی که وارد آزمایشگاه میشوید و در طول چرخه عمر محصول به پیامدهای آن فکر کنید. من میتوانم بیشمار مشکلات احتمالی را تصور کنم [در ارتباط با مدلهایی مانند این] که میتوانند به آیندهای دیستوپیایی منجر شوند، جایی که احساسات شما تعیین میکند که آیا شغل، وام یا پذیرش در دانشگاه را دریافت میکنید یا خیر.

دیدگاهتان را بنویسید