شرکت انویدیا با گسترش اکوسیستم هوش مصنوعی خود، «Chat with RTX» را معرفی کرده، یک چت بات برای PCهای ویندوزی که توسط TensorRT-LLM پشتیبانی میشود و به صورت رایگان در جدیدترین کارت گرافیکهای RTX در دسترس است.

شرکت انویدیا قصد دارد ChatGPT را با چت ربات محلی خود یعنی «Chat with RTX» که به صورت رایگان در پردازندههای گرافیکی RTX 30 و 40 در دسترس است جایگزین کند.

این ابزار چت ربات بسیار ساده است و به عنوان یک سیستم محلی طراحی شده که به این معنی است که شما یک ربات چت شخصی GPT را همیشه در PC خود بدون نیاز به آنلاین شدن در دسترس خواهید داشت. Chat with RTX را میتوان با استفاده از مجموعه دادهای که به صورت محلی در PC شما در دسترس است کاملاً شخصی سازی کرد. بهترین بخش این است که این ابزار تقریباً در تمام کارت گرافیکهای RTX 40 و RTX 30 اجرا میشود.

مشخصات چت بات Chat with RTX

ابزار Chat with RTX از نرمافزار TensorRT-LLM و Retrieval Augmented Generated (RAG) NVIDIA استفاده میکند که سال گذشته برای PCهای ویندوزی معرفی شد و از شتاب RTX موجود در سختافزار RTX برای ارائه بهترین تجربه ممکن به کاربران بهره میبرد. بار دیگر باسد گفت، این برنامه در تمامی کارت گرافیکهای GeForce RTX 30 و 40 با حداقل 8 گیگابایت حافظه ویدیویی پشتیبانی میشود.

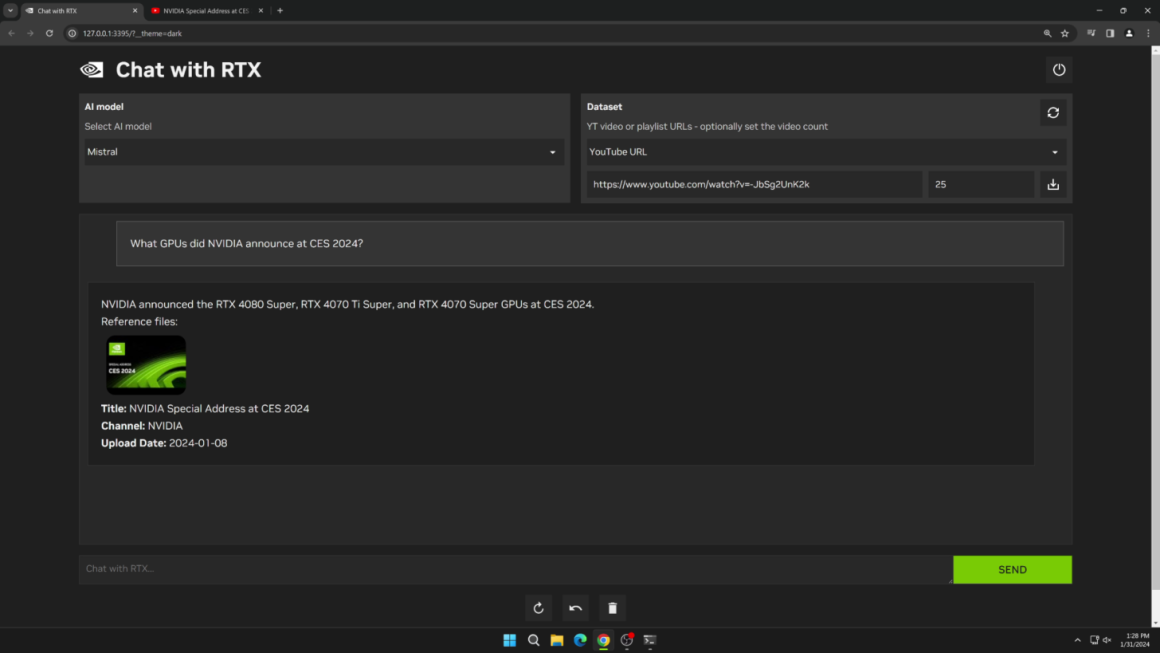

پس از دانلود رایگان «Chat with RTX»، کاربران میتوانند آن را به مجموعه دادههای محلی موجود در PC خود (txt، .pdf، .doc.، .docx، .xml) وصل کنند و آن را به یک مدل زبان بزرگ مانند Mistral و Llama 2 متصل کنند. همچنین میتوانید URL های خاصی را برای مثال برای ویدیوهای YouTube یا کل لیستهای پخش اضافه کنید تا نتایج جستجوی مجموعه داده را بیشتر کنید. پس از اتصال، کاربران میتوانند Chat With RTX را به همان روشی که از ChatGPT با پرسیدن سوالات مختلف استفاده میکنند به کار ببرند، اما نتایج ایجاد شده کاملاً بر اساس یک مجموعه داده خاص است و در مقایسه با روشهای آنلاین به شما پاسخ های بهتری میدهد.

داشتن یک کارت گرافیک NVIDIA RTX که از TensorRT-LLM پشتیبانی میکند به این معنی است که شما تمام دادهها و پروژههای خود را به جای ذخیره در فضای ابری به صورت محلی در دسترس خواهید داشت. این باعث صرفه جویی در زمان و ارائه نتایج دقیقتر میشود. RAG یا Retrieval Augamanted Generation یکی از تکنیکهایی است که برای سریعتر کردن نتایج هوش مصنوعی با استفاده از یک کتابخانه محلیسازی شده استفاده میشود که میتواند با مجموعه دادهای پر شود که میخواهید LLM از آن عبور کند و سپس از قابلیتهای درک زبان آن LLM برای ارائه اطلاعات دقیق به شما استفاده میکند.

شرکت انویدیا افزایش عملکرد 5 برابری را با TensorRT-LLM نسخه 0.6.0 نوید میدهد که اواخر این ماه در دسترس خواهد بود. علاوه بر این، پشتیبانی از LLM های اضافی مانند Mistral 7B و Nemotron 3 8B را نیز فعال خواهد کرد.

برنامه «Chat with RTX» شرکت انویدیا توسط PCهای ویندوز 11 و ویندوز 10 پشتیبانی میشود و برای عملکرد مطلوب به آخرین درایورهای گرافیکی شرکت انویدیا نیاز دارد.

دیدگاهتان را بنویسید