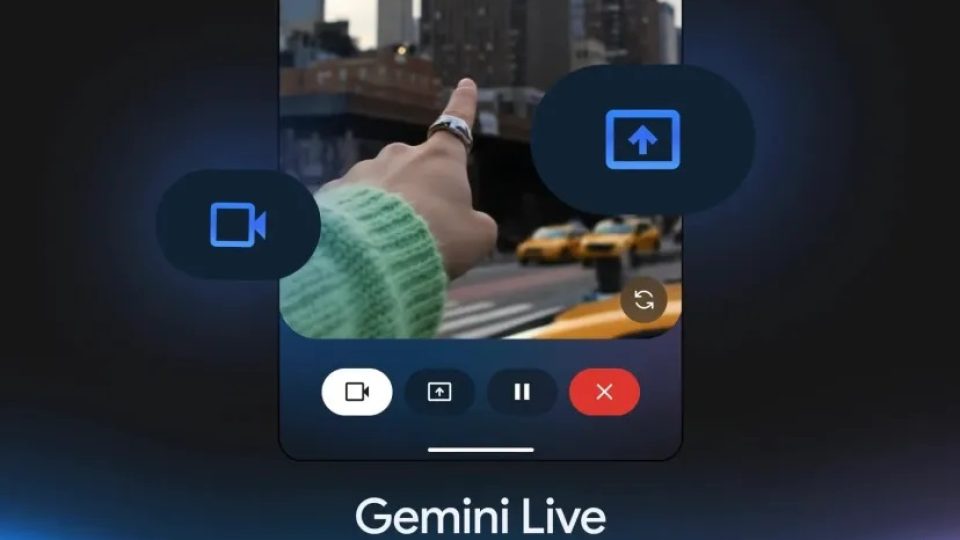

گوگل در کنفرانس توسعهدهندگان I/O، دو روش جدید برای دسترسی به حالت «Live» مبتنی بر هوش مصنوعی خود را معرفی کرد که به کاربران این امکان را میدهد تا دوربین خود را به سمت هر چیزی بگیرند و در مورد آن جستجو کرده و سوال بپرسند. این ویژگی به عنوان بخشی از حالت هوش مصنوعی (AI Mode) به جستجوی گوگل اضافه خواهد شد و همچنین در برنامه Gemini در iOS نیز ارائه میشود.

قابلیت اشتراکگذاری دوربین سال گذشته در Google I/O به عنوان بخشی از پروژه آزمایشی Astra این شرکت، قبل از عرضه رسمی به عنوان بخشی از Gemini Live در اندروید، آغاز شد. این ویژگی به چتبات هوش مصنوعی این شرکت اجازه میدهد تا همه چیز را در فید دوربین شما ببیند. بنابراین میتوانید مکالمهای مداوم در مورد دنیای اطراف خود داشته باشید. به عنوان مثال، میتوانید پیشنهاد دستور غذا بر اساس مواد موجود در یخچال خود را درخواست کنید.

گوگل اکنون این قابلیت را مستقیماً به همراه Google Lens به AI Mode جدید جستجو میآورد. در نتیجه با ضربه زدن روی آیکون «Live»، کاربران میتوانند دوربین خود را برای جستجو به اشتراک بگذارند و مستقیماً در مورد آنچه در مقابلشان است، سؤال بپرسند.

این قابلیت که با نام تجاری «Live Search» معرفی شده، تا «اواخر تابستان امسال» ارائه نخواهد شد و ابتدا به صورت بتا برای کاربران آزمایشگاه گوگل در دسترس خواهد بود.

از سوی دیگر برنامه Gemini در iOS با همین ویژگی، امکان صحبت کردن با Gemini در مورد آنچه روی صفحه نمایش است را ارائه میدهد. اشتراکگذاری دوربین و صفحه نمایش ماه گذشته در Gemini Live در Pixel 9 و Galaxy S25 راهاندازی شد. گوگل در ابتدا قصد داشت این ویژگی را برای اشتراک پولی Gemini Advanced خود قفل کند، اما نظر خود را تغییر داد، بنابراین این قابلیت هم برای کاربران iOS و هم کاربران Android رایگان خواهد بود.

دیدگاهتان را بنویسید